Inteligența artificială socialistă: Autoritățile de reglementare chineze analizează modelele GenAI pentru „valori socialiste fundamentale”

Companiile de inteligență artificială din China sunt supuse unei revizuiri guvernamentale a modelelor lor lingvistice mari, cu scopul de a se asigura că acestea „întruchipează valorile socialiste fundamentale”, conform Financial Times, scrie CNBC.

Revizuirea este efectuată de Administrația spațiului cibernetic din China (CAC), principala autoritate guvernamentală de reglementare a internetului, și va acoperi jucători din întreaga gamă, de la giganți tehnologici precum ByteDance și Alibaba până la mici startup-uri.

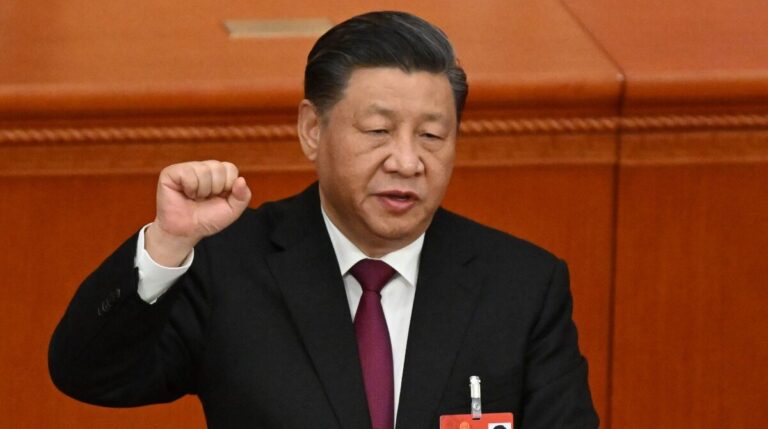

Modelele de inteligență artificială vor fi testate de oficialii locali ai CAC în ceea ce privește răspunsurile lor la o serie de întrebări, multe legate de subiecte sensibile din punct de vedere politic și de președintele chinez Xi Jinping, scrie Financial Times. De asemenea, vor fi examinate datele de formare și procesele de siguranță ale modelului.

O sursă anonimă de la o companie de inteligență artificială din Hangzhou care a vorbit cu FT a declarat că modelul lor nu a trecut prima rundă de testare din motive neclare. Ei au trecut doar a doua oară după luni de „presupuneri și ajustări”.

Cele mai recente eforturi ale CAC ilustrează modul în care Beijingul a încercat să recupereze decalajul față de SUA în ceea ce privește GenAI și, în același timp, a supravegheat îndeaproape dezvoltarea tehnologiei, asigurându-se că conținutul generat de AI aderă la politicile sale stricte de cenzură a internetului.

Țara a fost printre primele care au finalizat anul trecut normele care reglementează inteligența artificială generativă, inclusiv cerința ca serviciile AI să adere la „valorile fundamentale ale socialismului” și să nu genereze conținut „ilegal”.

Respectarea politicilor de cenzură necesită „filtrarea de securitate” și a fost complicată deoarece LLM-urile chineze sunt încă instruite pe o cantitate semnificativă de conținut în limba engleză, au declarat pentru FT mai mulți ingineri și persoane din interiorul industriei.

Potrivit raportului, filtrarea se face prin eliminarea „informațiilor problematice” din datele de formare ale modelului AI și apoi prin crearea unei baze de date de cuvinte și fraze care sunt sensibile.

Se pare că reglementările au determinat cele mai populare chatbots din țară să refuze adesea să răspundă la întrebări pe teme sensibile, cum ar fi protestele din Piața Tiananmen din 1989.

Cu toate acestea, în timpul testării CAC, există limite privind numărul de întrebări pe care LLM-urile le pot refuza categoric, astfel încât modelele trebuie să fie capabile să genereze „răspunsuri corecte din punct de vedere politic” la întrebări sensibile.

Un expert în inteligență artificială care lucrează la un chatbot în China a declarat pentru FT că este dificil să se împiedice LLM-urile să genereze tot conținutul potențial dăunător, astfel încât, în schimb, ei construiesc un strat suplimentar pe sistem care înlocuiește răspunsurile problematice în timp real.

Reglementările, precum și sancțiunile americane care au restricționat accesul la cipurile utilizate pentru formarea LLM, au îngreunat lansarea de către firmele chineze a propriilor servicii de tip ChatGPT. Cu toate acestea, China domină cursa globală în ceea ce privește brevetele de IA generativă.

Urmărește mai jos producțiile video ale G4Media:

Donează lunar pentru susținerea proiectului G4Media

Donează suma dorită pentru susținerea proiectului G4Media

CONT LEI: RO89RZBR0000060019874867

Deschis la Raiffeisen BankCitește și...

© 2025 G4Media.ro - Toate drepturile rezervate

Acest site foloseşte cookie-uri.

Website găzduit de Presslabs.

4 comentarii